La estadística es una herramienta fundamental para comprender y analizar los datos en diversos campos. Dos conceptos que a menudo se utilizan en el análisis estadístico son la varianza y la desviación estándar. A simple vista, pueden parecer términos similares, pero en realidad tienen diferencias importantes. En este artículo, exploraremos la varianza y la desviación estándar, explicando qué son, cómo se calculan y cuándo es necesario utilizar cada una. ¡Prepárate para sumergirte en el fascinante mundo de la estadística y descubrir cómo estos dos conceptos pueden ayudarnos a comprender mejor nuestros datos!

Diferencia entre varianza y desviación estándar

Varianza versus desviación estándar es el concepto matemático estadístico más utilizado. Sin embargo, también desempeñan un papel importante en todo el ámbito financiero, incluidas la economía, la contabilidad y las inversiones.

La variabilidad es otra jerga estadística que indica hasta qué punto las muestras u observaciones se desvían de la medida de tendencia central (que debe ser apropiada). Las medidas de dispersión se pueden dividir en dos categorías:

- Una medida relativa de la propagación y

- Una medida absoluta de dispersión.

Los dos tipos de medidas de variabilidad absoluta describen cómo se distribuyen las muestras u observaciones alrededor de la media o la varianza media y la desviación estándar. Interpretación de la varianza como el promedio de los cuadrados de las desviaciones.

A diferencia de la varianza, la desviación estándar es la raíz cuadrada del valor (numérico) que se calcula al calcular la varianza. La mayoría de la gente contrasta estos dos conceptos matemáticos y discutiremos lo mismo.

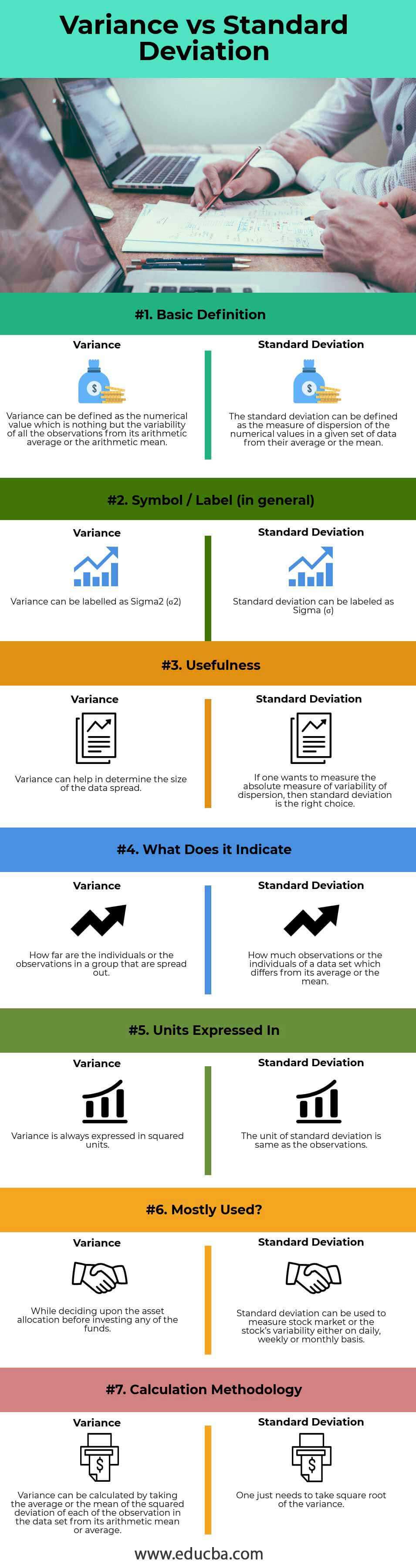

Comparación directa entre varianza y desviación estándar (infografía)

A continuación se muestran las siete diferencias clave entre la varianza y la desviación estándar.

Diferencias clave entre varianza y desviación estándar

Tanto las variaciones como las desviaciones estándar son opciones populares en el mercado. Analicemos algunas de las diferencias clave entre varianza y desviación estándar.

- La varianza es el valor numérico que describe la variabilidad de individuos u observaciones a partir de su media aritmética. Por otro lado, la desviación estándar es otra medida de la dispersión de individuos u observaciones dentro de un conjunto de datos particular.

- Como ya se mencionó, la varianza mide qué tan ampliamente distribuidos están los individuos u observaciones en un grupo o muestra. Por el contrario, la desviación estándar mide cuánto se desvían los individuos u observaciones de un conjunto de datos determinado de su promedio o media aritmética.

- La varianza se puede indicar o etiquetar mediante sigma cuadrado (σ).2), mientras que la desviación estándar puede denominarse o etiquetarse como sigma (es decir, σ).

- La varianza, como ya se mencionó, no es más que un promedio o la media de las desviaciones al cuadrado. Por el contrario, la desviación estándar es la raíz cuadrática media o la raíz cuadrática media de la desviación.

- Las unidades cuadradas siempre expresan la varianza, que generalmente es mayor o mayor que los valores de las observaciones o de los individuos en el conjunto de datos dado. Por el contrario, la desviación estándar se expresa en las mismas unidades que los valores de las observaciones o de los individuos en el conjunto de datos dado.

Tabla de comparación entre varianza y desviación estándar

A continuación se muestran las 7 comparaciones más importantes entre varianza y desviación estándar

| Base de comparación |

Diferencia |

Desviación Estándar |

| Definición básica | La varianza se puede definir como un valor numérico, la desviación de todas las observaciones de su media aritmética o la media aritmética. | La desviación estándar mide la dispersión de valores numéricos en un conjunto de datos determinado desde su promedio o media. |

| Símbolo/etiqueta

(En general) |

La varianza se puede denominar sigma.2 (σ2) | La desviación estándar puede denominarse sigma (σ). |

| utilidad | La varianza puede resultar útil para determinar el tamaño de la distribución de datos. | Si se quiere medir la medida absoluta de la variabilidad de la dispersión, la desviación estándar es la elección correcta. |

| ¿Qué significa? | ¿Qué tan ampliamente están distribuidos los individuos u observaciones en un grupo? | ¿Cuántas observaciones o individuos en un conjunto de datos se desvían de su promedio o media? |

| Unidades expresadas en | Informa la varianza en unidades al cuadrado. | La unidad de desviación estándar es la misma que la de las observaciones. |

| ¿Mayormente usado? | Al decidir la asignación de activos antes de invertir en cualquiera de los fondos. | La desviación estándar puede medir el mercado de valores o las fluctuaciones de las acciones de forma diaria, semanal o mensual. |

| Metodología de cálculo | Para calcular la varianza, tome el promedio o la desviación cuadrática media de cada observación en el conjunto de datos de su media o promedio aritmético. | Todo lo que tienes que hacer es sacar la raíz cuadrada de la varianza. |

Diploma

Tanto la varianza como la desviación estándar son conceptos matemáticos comunes que se utilizan en estadística y teoría de probabilidad para medir la varianza o la dispersión. La varianza, como hemos comentado, es una medida absoluta de dispersión de cuán ampliamente se distribuyen las observaciones o valores o en qué medida se desvían de su promedio aritmético o de la media aritmética en un conjunto de datos determinado, mientras que la desviación estándar, por otro lado Por otro lado, es una medida de dispersión (de nuevo una medida absoluta) de las observaciones o de los valores que son relativos al promedio o media.

La varianza se puede calcular como el promedio o la desviación cuadrática media de cada observación o como un valor de la media en un conjunto de datos particular, mientras que la desviación estándar no es más que simplemente tomar la raíz cuadrada de la varianza calculada. Mencioné anteriormente que las medidas de desviación estándar de una unidad son similares al promedio o la media.

La unidad al cuadrado de la media o varianza de la media. Tanto las varianzas como las desviaciones estándar tienen sus propósitos. La varianza expresa la variabilidad de los datos, mientras que la desviación estándar describe principalmente la variabilidad de los datos en un conjunto particular. Sin embargo, son similares; La varianza versus la desviación estándar siempre es positiva. Si todas las observaciones en un conjunto de datos determinado son similares o idénticas, la varianza y la desviación estándar son cero.

Estos dos son los conceptos estadísticos más básicos que juegan un papel importante en diferentes sectores. Los usuarios prefieren la desviación estándar sobre el promedio o la media porque expresa medidas en unidades similares a los datos. Por el contrario, el conjunto de datos dado normalmente expresa la varianza en unidades cada vez mayores.

Finalmente, estos dos conceptos miden la volatilidad del mercado, lo que ayuda a desarrollar una estrategia comercial rentable.

Artículos recomendados

Esto determinó la mayor diferencia entre la varianza y la desviación estándar. Aquí analizamos las diferencias clave entre la varianza y la desviación estándar utilizando infografías y la tabla de comparación. También puedes echar un vistazo a los siguientes artículos para obtener más información.

- Contabilidad versus gestión financiera

- Contabilidad de acumulación versus contabilidad de caja

- Contabilidad pública versus privada

- Cuenta corriente versus cuenta de capital