En el mundo de las matemáticas, el estudio de los conjuntos es esencial. Los conjuntos son una herramienta fundamental que nos permite agrupar elementos de manera lógica y ordenada. En este artículo, exploraremos diferentes métodos de conjunto, es decir, técnicas y estrategias que nos permiten operar y analizar conjuntos de manera eficiente. ¿Listo para adentrarte en el fascinante mundo de los métodos de conjunto? ¡Sigue leyendo!

Combinar múltiples modelos para mejorar los resultados deseados

Más de 1,8 millones de profesionales utilizan CFI para aprender contabilidad, análisis financiero, modelado y más. Comience con una cuenta gratuita para explorar más de 20 cursos siempre gratuitos y cientos de plantillas financieras y hojas de trucos.

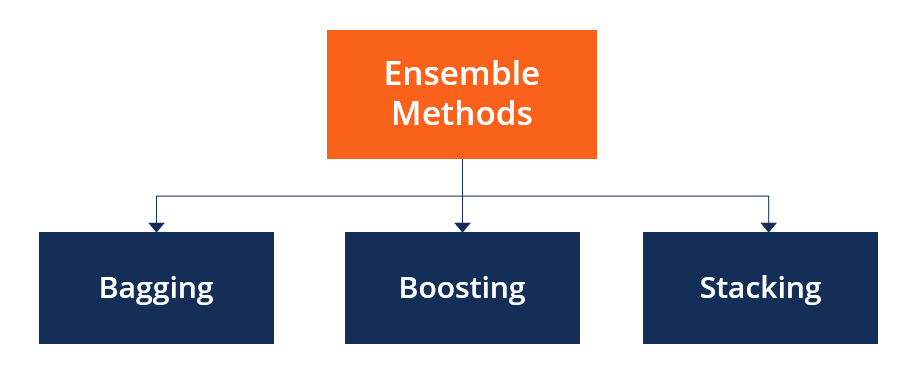

¿Qué son los métodos de conjunto?

Los métodos de conjunto son técnicas que tienen como objetivo mejorar la precisión de los resultados en los modelos combinando varios modelos en lugar de utilizar un solo modelo. Los modelos combinados aumentan significativamente la precisión de los resultados. Esto ha aumentado la popularidad de los métodos conjuntos en el aprendizaje automático.

Resumen

- Los métodos de conjunto tienen como objetivo mejorar la previsibilidad de los modelos combinando múltiples modelos en un modelo altamente confiable.

- Los métodos de conjunto más populares son el refuerzo, el embolsado y el apilamiento.

- Los métodos de conjunto son ideales para la regresión y la clasificación, donde reducen el sesgo y la varianza para aumentar la precisión de los modelos.

Categorías de métodos de conjunto

Los métodos de conjunto se pueden dividir en dos categorías amplias: técnicas de conjunto secuencial y técnicas de conjunto paralelo. Técnicas de conjunto secuencial. Generar alumnos básicos en una secuencia, p. B. Impulso adaptativo (AdaBoost). La generación secuencial de alumnos base promueve la dependencia entre los alumnos base. Luego, el rendimiento del modelo se mejora asignando ponderaciones más altas a los alumnos que antes estaban mal representados.

En Técnicas de conjuntos paralelosLos alumnos base se generan en un formato paralelo, p. Por ejemplo, bosque aleatorio. Los métodos paralelos utilizan la generación paralela de alumnos base para promover la independencia entre los alumnos base. La independencia de los alumnos de base reduce significativamente el error por la aplicación de medias.

La mayoría de las técnicas de conjunto aplican un único algoritmo en el aprendizaje base, lo que da como resultado homogeneidad entre los alumnos base. Los alumnos de base homogéneos se refieren a alumnos de base del mismo tipo con características similares. Otros métodos aplican alumnos de base heterogéneos, lo que da como resultado conjuntos heterogéneos. Los estudiantes básicos heterogéneos son estudiantes de diferentes tipos.

Principales tipos de métodos de conjunto.

1. Empacar

Bagging, abreviatura de agregación bootstrap, se utiliza principalmente en clasificación y regresión. Aumenta la precisión de los modelos a través de árboles de decisión, reduciendo así significativamente la varianza. La reducción de la varianza aumenta la precisión y evita el sobreajuste, que es un desafío para muchos modelos predictivos.

El embolsado se clasifica en dos tipos: bootstrapping y agregación. Arranque es una técnica de muestreo que utiliza el método de reemplazo para derivar muestras de toda la población (conjunto). El método de muestreo con reemplazo ayuda a aleatorizar el proceso de selección. El algoritmo de aprendizaje base se ejecuta en los ejemplos para completar el proceso.

acumulación El embolsado implica incluir todos los resultados posibles de la predicción y aleatorizar el resultado. Sin agregación, las predicciones no son correctas porque no se tienen en cuenta todos los resultados. Por tanto, la agregación se basa en procedimientos probabilísticos de bootstrapping o en base a todos los resultados de los modelos de predicción.

El embolsado es beneficioso porque los alumnos de base débil se combinan en un único alumno fuerte, que es más estable que los alumnos individuales. También elimina cualquier variación, reduciendo así el sobreajuste de modelos. Una limitación del embolsado es que requiere mucho cálculo. Por lo tanto, ignorar el procedimiento de embolsado adecuado puede generar un mayor sesgo en los modelos.

2. Impulsar

El impulso es una técnica de conjunto que aprende de los errores de predicción pasados para hacer mejores predicciones en el futuro. La técnica combina varios alumnos de base débil en un alumno fuerte, lo que mejora significativamente la previsibilidad de los modelos. El impulso funciona organizando a los alumnos débiles en un orden de modo que los alumnos débiles aprendan del siguiente alumno para construir mejores modelos predictivos.

El impulso puede tomar muchas formas, incluido el impulso de gradiente, el impulso adaptativo (AdaBoost) y XGBoost (impulso de gradiente extremo). AdaBoost utiliza alumnos débiles en forma de árboles de decisión, que en su mayoría implican una división conocida popularmente como tocones de decisión. El principal hilo de decisión de AdaBoost consta de observaciones con un peso similar.

El aumento de gradiente agrega predictores al conjunto uno a la vez, y los predictores anteriores corrigen a sus sucesores, lo que aumenta la precisión del modelo. Los nuevos predictores son capaces de contrarrestar los efectos de los errores de los predictores anteriores. El gradiente de descenso ayuda al potenciador de gradiente a detectar problemas en las predicciones de los alumnos y contrarrestarlos en consecuencia.

XGBoost aprovecha los árboles de decisión mejorados por gradiente para mejorar la velocidad y el rendimiento. Depende en gran medida de la velocidad informática y el rendimiento del modelo de destino. El entrenamiento del modelo debe seguir un orden, lo que ralentiza la implementación de máquinas de impulso de gradiente.

3. Apilamiento

El apilamiento, otro método de conjunto, a menudo se denomina generalización apilada. Esta técnica permite que un algoritmo de entrenamiento combine múltiples predicciones similares de algoritmos de aprendizaje. El apilamiento se ha implementado con éxito en regresión, estimación de densidad, aprendizaje a distancia y clasificación. También se puede utilizar para medir la tasa de error durante el llenado.

Reducción de varianza

Los métodos de conjunto son ideales para reducir la varianza en los modelos y así aumentar la precisión de las predicciones. La varianza se elimina cuando se combinan varios modelos en una única predicción seleccionada de todas las demás predicciones posibles de los modelos combinados. Un conjunto de modelos combina diferentes modelos para garantizar que la predicción resultante sea la mejor posible basándose en la consideración de todas las predicciones.

Recursos adicionales

Para avanzar aún más en su carrera, los siguientes recursos adicionales de CFI le resultarán útiles: